今年,GEO 特别热。

年底了,上周和同事见了两波专做 GEO 的团队,拿到一些最新的行业认知。今天写篇文章来分享下。

我们都能感觉到,用户的习惯在快速变化。像我以前找信息会习惯打开谷歌或百度,输入关键词查找对应的可能命中答案的网页。但现在,我则是已经彻底习惯跑到 ChatGPT 之类的 AI 应用中,用自然语言的方式描述问题,他们会直接给出来我们答案。

包括百度、谷歌这样搜索产品,他们也都加了 AI 模式。这是一个既定的趋势。

1

过去十多年时间,SEO 是互联网的重要议题。因为当搜索成为用户的入口之后,大家想获得流量,就需要想尽办法能让自己的产品网站靠前。

但现在,毫无疑问,SEO 的权重在降低。取而代之的是 GEO(Generative Engine Optimization)。也有人把 GEO 称之为 AEO(Answer Engine Optimization)。不纠结概念,他们说的都是一回事。

GEO 本质是让产品在大模型的答案里被提得更多。

大模型在回答问题时,不再是从某一篇网页里摘一段,而是会把全网和语境相关的内容一起看,然后重新组织成一句顺畅的回答。

它会先理解问题的意图,再在自己的知识范围里找出能够解释这个问题的证据,最后把这些证据整理成一句自然语言的总结。

这也带来了一个很直接的结果:

谁在模型能看到的内容世界里出现得多,谁被提到的次数稳定,谁的内容与主题关联度更高,谁就更容易进入最后的答案里。

这就是 GEO 的起点,也是它在这个阶段突然变得重要的根本原因。

如果用更简洁的方式解释:SEO 关注的是内容排在第几。GEO 关注的是内容会不会被模型拿来反复使用。一个是排名问题,一个是引用问题。

大模型倾向复用那些信息更完整、覆盖度更高、在相关主题里出现频繁的内容,而不是页面做得更华丽的内容。

比如一个产品教程,如果只讲了基础功能,模型会觉得信息增量有限,那它引用你的概率会明显下降。但如果你的内容覆盖了用户会问的长尾问题,解释了背后的原因,有连续的上下文,甚至有真实用户讨论,模型会更愿意反复拿来当证据源。

理解了 GEO 的底层逻辑之后,问题变得非常现实:既然模型看的是引用,那我们到底该怎么办,模型才更愿意引用我们。

过去做 SEO,本质上是围绕搜索引擎的规则来调整内容,让算法更容易识别我们、理解我们、把我们排在前面。

但 GEO 面向的是大模型。模型不按关键词找,它按语义理解;模型不看单页权重,它看的是全域信息图谱。它不在乎页面是否精修,而在乎你能不能真正解释一个主题。

2

目前 GEO 虽然还在早期,但行业里经过验证,真正有效的做法已经开始收敛成三条线。

第一条线:把基础内容做扎实。

大模型的阅读方式和人完全不一样,它会把内容拆成意义单元,去判断这个页面到底能不能帮它解释一个问题。如果只有几句概念性的介绍,它会直接跳过,因为信息密度太低,它从中得不到任何增量。

反过来,当一个主题被拆开讲清楚时,模型的反应非常明显。

比如一个功能为什么这样设计,使用过程中可能遇到什么情况,同类产品的差别在哪,用户常见的困惑是什么,这些都属于高价值的语义片段。模型会把它们当成更可靠的证据,因为这些内容在别处不容易找到,也能帮助它更完整地回答问题。

越是能解释逻辑、越是能覆盖长尾场景、越是能把底层原因讲透的内容,被模型引用的概率越高。模型偏好带结构、有因果、有背景、有上下文的内容,因为它能从中捕获到真实的语义关系,而不是空洞的描述。

一个洞察是,模型不仅在找“是什么”,更是在找“为什么”和“怎么用”。

如果基础内容里有产品使用的来龙去脉,有设计背后的考量,有实际操作时的细节,有从场景出发的解释,模型会自然把这些信息当成可以复用的节点。它不是把内容复制过去,而是把内容拆成知识,并在后续回答中反复调用。

第二条线:真实的讨论很重要。

模型在处理内容时,有一类信息权重特别高,就是来自真实讨论的语料。因为这里面天然带着情境、追问、疑惑、争论、反对、澄清,这些都是自然语言最难伪造也最有价值的部分。

相比官网介绍那种单向陈述,真实讨论包含了丰富的语义线索,能让模型捕捉到更加细致的理解方式。

国外做 GEO 的团队之所以几乎都盯着 Reddit,不是因为 Reddit 流量大,而是因为 Reddit 的内容形态对模型特别友好。一个话题往往从一个简单提问开始,接下来会有各种角度的回答,每个回答又可能被追问、补充、反驳。

当一个主题在真实讨论里出现得足够多时,模型就能借助这些讨论形成对这个主题的真正理解。它不仅知道表面的功能描述,还能知道使用时的细节、用户的情绪、踩坑的经过、不同场景的差异、各种做法的利弊。

这些都是模型最缺的视角。

第三条线:多元的内容覆盖。

模型在生成答案时,会同时从很多来源找证据,它不会依赖一个页面,也不会只看某个平台。它的过程更像是在拼一幅大图,品牌的存在感不是通过某一次出现建立的,而是通过在不同语境、不同角度、不同内容类型里持续曝光累积起来的。

行业里已经有越来越多的例子可以证明,GEO 的重点不是曝光量本身,而是把内容放在模型能够抓取的地方。

深度文章、行业观点、媒体报道、案例拆解、技术分析、产品故事,这些形式共同构成了一个主题的背景知识,而背景知识恰恰是模型回答问题时最常被引用的部分。

当一个话题被提起时,模型会自动寻找它熟悉的证据。如果你在不同类型的内容里反复被提到,无论是观点、经验、分析还是案例,它都会把你视为这个话题的一部分,而不是偶尔出现的点。特别是当这些内容来自不同平台、不同行业媒体、不同语境时,你在模型知识网络里的密度会显著提升。

经过验证,专业博客、媒体深度稿、权威分析报告,往往是模型非常依赖的信息源。它们提供的不是碎片,而是结构化的背景,很多时候是模型组织答案的底座。这类内容出现得越多,被引用的机会越大。

3

前面的第一条线和第三条线,其实做过 SEO 的同学会很熟悉。

内容要做扎实,要把产品相关的主题都写清楚,这一块可以参考黄金圆环模型。同时也需要在深度媒体和关键渠道里保持稳定的内容覆盖,让模型能够在不同来源里都能遇到产品。

这两条,我知道重视 GEO 的同学基本都在做。

因为这些做法的思路和过去 SEO 的底层逻辑有一定延续,只不过从优化页面,变成了让内容更清晰、更结构化,能让模型更容易读懂和引用。这些路径,大多数团队应该都能自然意识到要去做。

但第二条线完全不一样。

它的核心不在品牌自己写了什么,而在用户怎么聊。它也不看某一篇内容写得多好,而是看整条讨论里的人怎么来回交流。

很多时候,那些带着情绪、带着细节、带着场景的表达,模型反而更愿意用。

我和几个做 GEO 的朋友交流,他们一直认为:真实的讨论决定了一个平台在 GEO 阶段能不能成为关键节点,也决定了模型真正信任的语言结构来自哪里。

这也是为什么在海外,Reddit 会成为 AEO 策略里的核心位置。

Reddit 的讨论对模型来说不是内容,而是语料。它天然具备模型需要的几件事:多轮对话、真实语气、长尾问题、场景细节。

一个帖子下面几十上百条回复,把一个问题从不同角度拆开、碰撞、补充、反转,这种密度只有真实讨论能给。而大模型理解一个主题,靠的正是这种真实语境。

但中文互联网呢?有没有类似 Reddit 的平台?

有,但不是知乎,也不是微博。知乎现在已经没什么高质量的讨论,很多都在灌水,而微博,它的讨论又碎。

只有一个地方的结构与语料特征和 Reddit 高度类似,那就是百度贴吧。

4

你可能会说?百度贴吧不是都已经凉了?

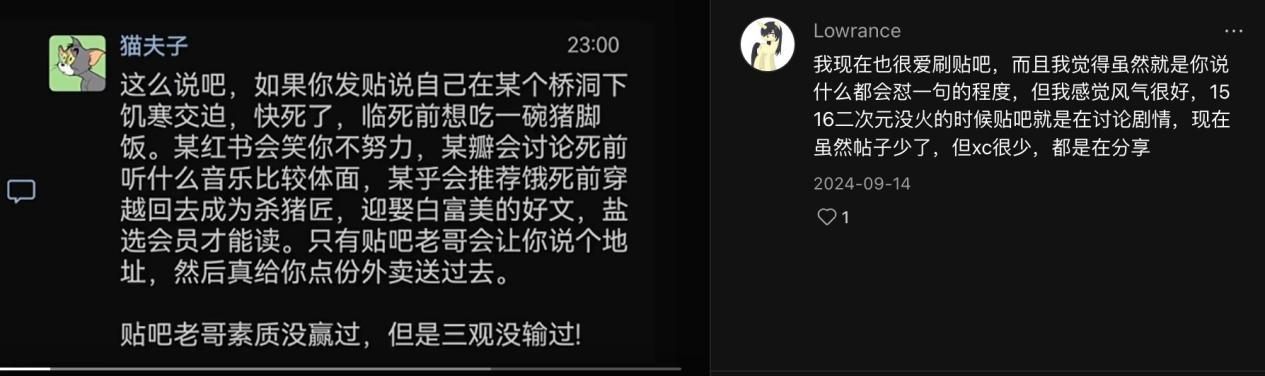

上周听朋友分享到这里,我内心也有类似的疑惑。拿出手机搜了下关键词,找到下面这样一条帖子。

再放一个我刷到的帖子:

我一下子就明白为什么国内的 Reddit 是百度贴吧了。

贴吧是天然的多轮对话格式。大模型最缺的就是长对话。长对话不是问一句答一句,而是一个人抛个问题,下面十几个人一起上来,你一句我一句,互相补充、互相怼、互相追问,楼层一天能盖到两三百楼。

这种内容,对大模型来说,简直就是宝。它符合模型训练的格式:主题 → 观点 → 追问 → 反驳 → 细化 → 反复交锋。

再往深里看,贴吧上有非常多的垂类讨论。

显卡、猫砂、考研、户外、摄影器材、城市……几乎任何具体的问题,都能在贴吧找到对应的吧,并且至少沉淀了五年、十年甚至更长时间。

一个主题不是一篇文章,而是无数个问题、无数种问法、无数个细节堆起来的知识层。对模型来说,官方教程只能告诉它概念是什么,而贴吧能让它知道怎么用、怎么选、怎么避坑,背后的原因是什么。

这是完全不同的两种信息密度。

还有一个可能不太会有人摆在台面上说的:贴吧的回答者,大多是混在那个领域好多年的深度玩家。他们可能话糙,但经验真的不糙。

这种人写的内容,看起来不华丽,但特别具体。不会告诉你大道理,只会告诉你我踩过什么坑、我怎么解决、你遇到这个情况十有八九是这里出了问题。

这种东西,是品牌自己永远写不出来的,但模型特别喜欢。

当你把这几件事放在一起,就会发现一个很有意思的情况:

贴吧之所以重新变得重要,不是因为它活跃,不是因为它潮,而是因为它身上的原生态长对话结构,刚好是大模型最缺的营养。

那小红书为什么不行?

不是因为内容不好,而是它的表达方式被平台习惯统一得太彻底。

短句、固定的情绪节奏、视觉排布、模板化的开头,这是小红书的优势,却也意味着语言被处理得太平滑。用户的犹豫、争论、推理和反复思考,被压成一条条视觉友好的笔记,信息细节减少了,语义线索也浅了。

模型想学的,是人真实的思考过程,而不是整理过的表达方式。

这就是为什么从 GEO 的角度看,百度贴吧更有利。

5

如果把上面这些逻辑落到实操上,我最近整理了一份自己最近学习的笔记,供大家参考:

1)把产品的核心关键词丢进模型,让它生成几十种不同问法,再结合客服聊天、销售常见问题、社区提问,整理一份问题清单。

2)围绕这些问题撰写可用的答案,至少包含:怎么解决、为什么这样、典型场景是什么。

3)给每个核心主题写一篇能讲通因果的大稿,从来龙去脉、原理到常见误区,一次性讲透,避免碎片化。

4)把用户的踩坑、翻车和解决办法整理出来,写成单独的内容,让模型更容易捕捉真实细节。

5)把内容结构整理得更易读:短段落、明确的步骤、小标题,让模型能正确拆成意义单元引用。

6)挑 3 到 5 个与你产品用户重叠度最高的百度贴吧、Reddit 社区,长期在里面以真人方式互动。

7)在这些百度贴吧、Reddit 里,认真地解决问题,不求品牌提得多,但求回答有用、有细节、有判断。

8)运营一个长期更新的教程,从入门到进阶,把同一个主题的讨论都沉淀在楼层里,让它自然长成多轮对话树。

9)邀请真实用户分享自己的使用经历,不要让他们写成案例稿,就写自己怎么用、哪里踩坑、结果怎么样。

10)在不同渠道保持统一的品牌名称。

11)在关键内容里自然绑定品牌名 + 使用场景,让模型在抓场景时顺手记住你。

12)定期在主流模型里搜索几十个问法,看眼下模型怎么描述你、有没有被提到、和谁并列出现。

13)选择 1 到 2 个阵地,持续输出深度长文,可以是自家博客、公众号,也可以是垂直媒体专栏,重点写原理解析、行业趋势、方案对比。

希望对你有启发。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

关键词: