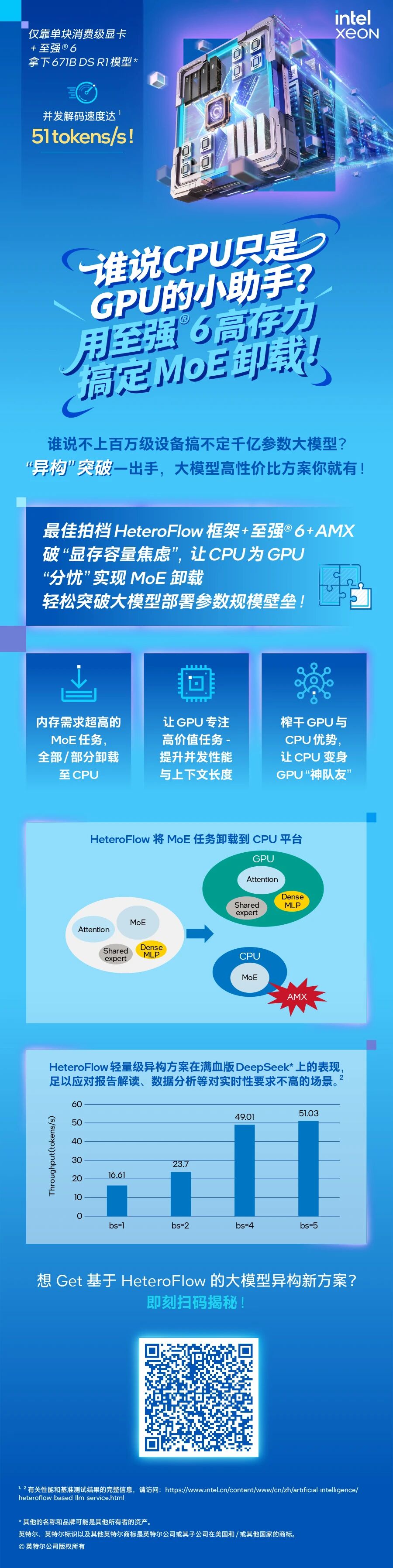

你敢想象:仅一台仅装备了单块24G显存消费级显卡的系统,不但能跑满血671B DeepSeek R1模型,还能带来5并发51 Token/秒的性能(更细节数据见下图),要知道这个性能水准,足以搞定像报告解读或数据分析这类对实时性要求不高的任务了。

这就是英特尔开发的全新异构LLM服务方案流出的最新测试数据,这个方案基于HeteroFlow软件框架,搭配了至强6性能核CPU(配MRDIMM内存,开启AMX加速)作为硬件基座,它的目标就是缓解 “满血”大模型们面临的存力困局。

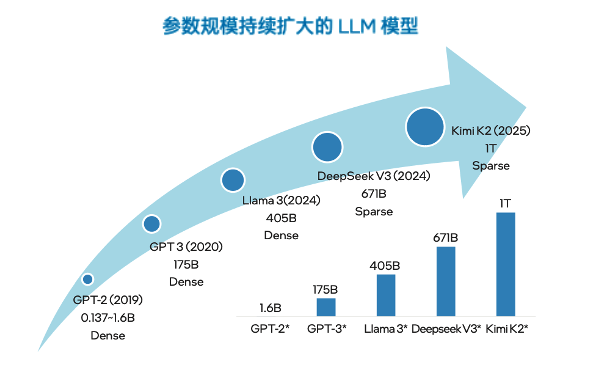

众所周知:大模型,是乐也“大参数”,痛也“大参数”——满血版动辄千亿级的参数规模,再叠加GPU大佬们在显存容量上的“精准”刀法,总能让你钱包严重失血!如果你就搞一个节点,即便GPU多卡插满,也就是能刚刚装下海量参数,剩余的显存会限制并发性能和上下文的长度。咬咬牙上多个节点,那就只能是……把牙咬碎,因为付出翻倍。

而现在,有了HeteroFlow框架的加持,如果你用的是MoE类大模型,且选择了英特尔的至强6性能核CPU来做机头处理器,那么恭喜你,破局方法来了!

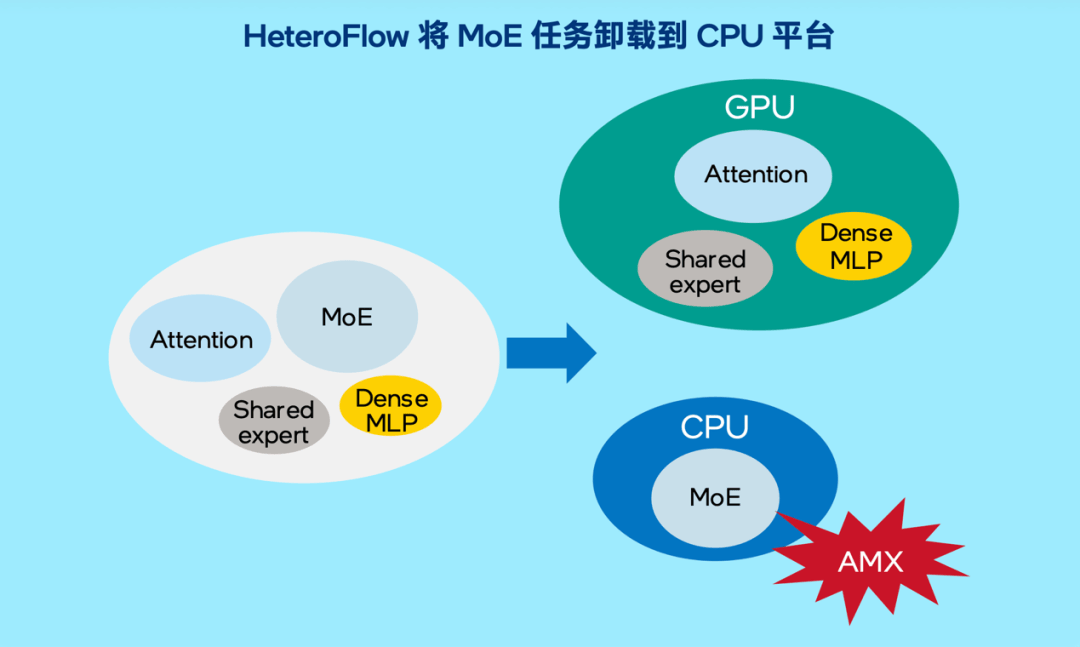

当然这个方法可能会颠覆你“AI让CPU走开”,或者“AI应用中CPU只是GPU小助手”的观念。但这个方法,恰恰是充分利用了GPU和CPU各自的优势——GPU算力强,CPU内存大。HeteroFlow的工作原理就是把Attention、Dense MLP这些算力敏感型的,也是高价值的任务留给高算力的GPU,但把MoE这种需要大存力的任务,部分或全部卸载给CPU+大容量的内存。

这种方法的终极奥义,并不是说CPU比GPU更重要,或者你不需要GPU了,而是有了CPU的分担与协助,GPU的工作更有意义了——它能把其成本高昂的算力和显存全用在榨取并发性能与上下文长度上,正所谓“好钢用在刀刃上”,让整个系统不仅性能收益明显,投资回报率也是原地起飞。

接下来,让我们瞧瞧HeteroFlow是怎样具体干活的:

一、卸载

对AI任务做智能拆分,把部分或全部MoE负载移到CPU上,让GPU更专注算力密集型任务,细节如下图。

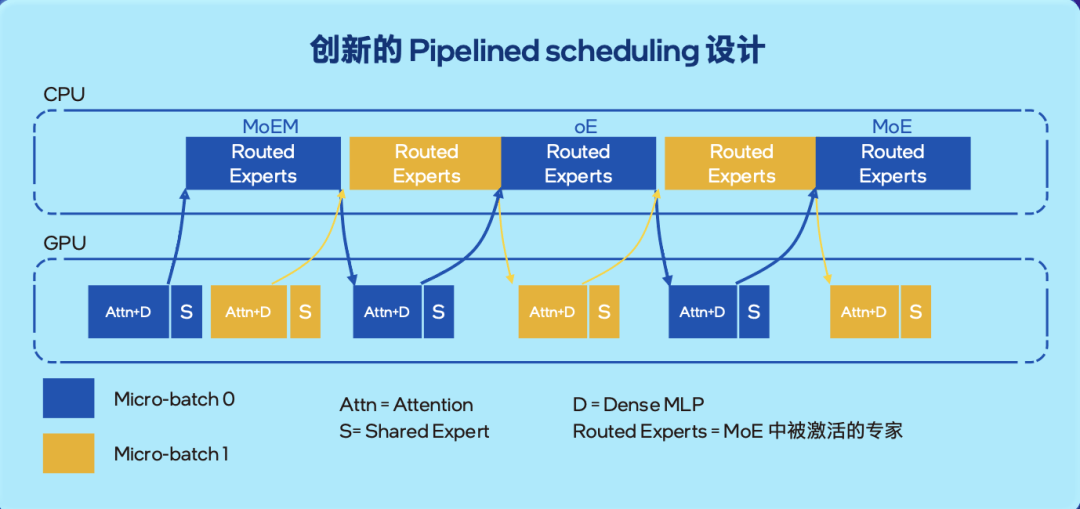

二、调度

通过Pipelined Scheduling设计,让CPU与GPU在各自承载的子任务间实现无缝衔接,最大化榨取它们各自的潜能,如下图:

三、加速

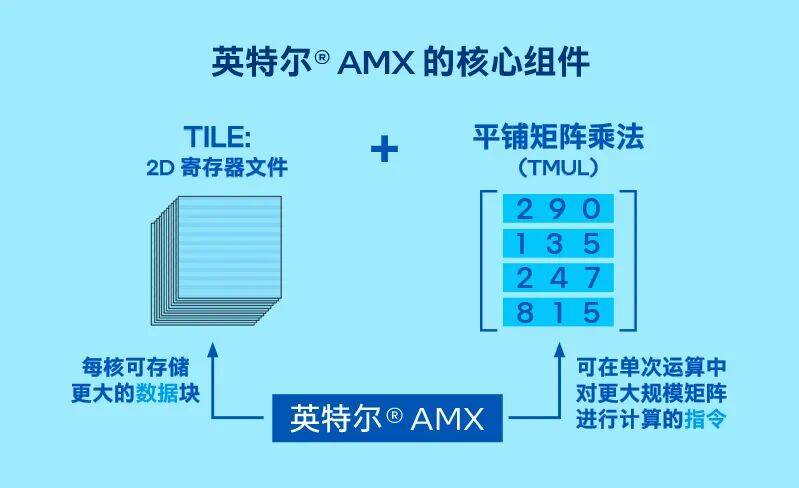

虽然至强CPU没有GPU那么强的AI加速算力,但它还是有自己的看家本领——英特尔AMX(高级矩阵扩展技术,有人将其比拟为“CPU里的Tensor Core”),它能为MoE任务涉及的计算提供加速。如果你对AMX技术没有那么了解,可以借下面两张图快速了解一下它的核心组件与架构,以及加速能力。

如果你比较细心,一定注意到我们在前文提到的是HeteroFlow框架 +至强6 性能核CPU这个组合,推荐这款CPU的原因很简单,因为它内置AMX技术,且主流型号(SKU),特别是用于机头的SKU能解锁对MRDIMM内存(8000/8800)的支持,几乎是目前市面上能同时兼顾内存的大容量与高带宽的惟一选择。

如果你还意犹未尽,觉得前文测试场景里的“低配”型系统和它实现的性能,还远远不能满足你一些更加“高大上”的需求,先别急,因为英持尔正在测试HeteroFlow+至强®6的另外两种应用场景:

1、在更多节点的、中量级的系统中,瞧它能不能把MoE中的“冷专家”(不常被激活的专家)卸载到CPU上,尽可能提升这类系统的并发度和拓展其上下文长度;

2、在更大或特大规模的AI集群中,当GPU出现单卡故障时,用CPU暂时顶一下,保障集群的稳定运行。

由衷期待这两个新场景能尽快落地,并有性能或性价比上的优异表现供大家分享。

你可以访问英特尔官网了解更多基于HeteroFlow框架的异构LLM服务方案的细节,或者联系英特尔官方得到英特尔相关技术专家的支持。

谁说CPU只是GPU的小助手?用至强® 6高存力搞定MoE卸载!

想Get基于HeteroFlow的大模型异构新方案?

欢迎访问英特尔官网,即刻揭秘!

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

关键词: