机器之心报道

编辑:维度

人脸风格迁移出现新玩法!捷克理工大学联合 Snap 公司创建了一个用于视频中人脸风格实时迁移的框架,既不需要大型数据集和冗长训练周期,更能够在移动端运行。

今年,人脸视频特效在全球又大火特火了一把。年初的「蚂蚁牙黑」(人脸唱歌),还有不久前让老照片动起来的特效,效果都十分惊艳。

风格迁移一直是图像领域的热门方向。那么在视频上做实时人脸画风迁移效果怎么样呢?

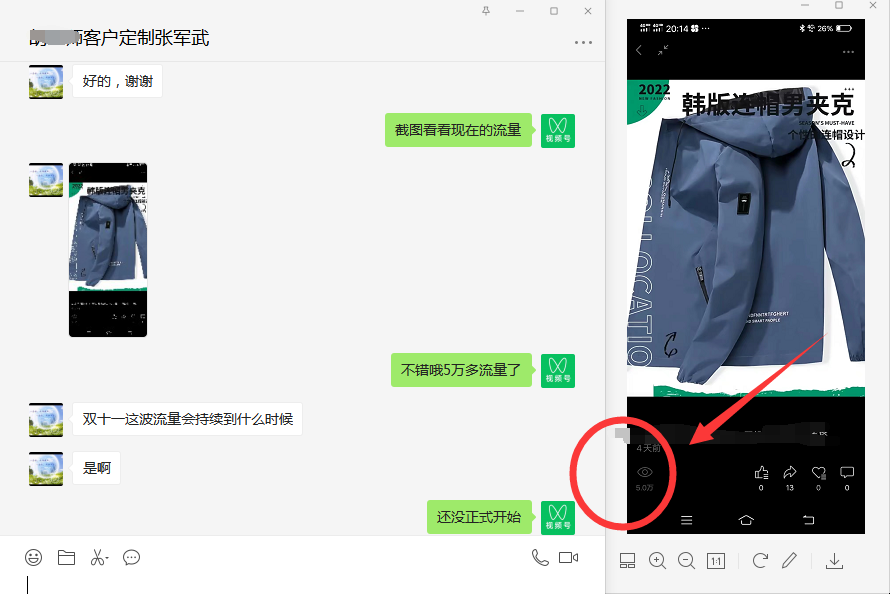

是这样的:

当然,视频画风迁移并不是什么新鲜技术了。但这项研究最大的特点在于:移动端、实时,由布拉格捷克理工大学和 Snap 公司的研究者联合完成。目前已经放出了完整论文,相关代码将于下月发布。

项目地址:https://ondrejtexler.github.io/faceblit/

论文地址:https://ondrejtexler.github.io/res/faceblit-paper.pdf

具体而言,研究者提出了一种基于实例的实时视频人脸风格迁移框架 FaceBlit,该框架通过语义上有意义的方式保留了风格的纹理细节,也就是说,用于描绘特定风格特征的笔画出现在目标图像的适当位置。

与以往风格迁移方法相比,该框架不仅保留了目标对象(target subject)的身份,而且不需要大型数据集和冗长训练周期即可实现实时运行。

为此,研究者修改了 Fi er 等人(2017 年)的人脸风格化 pipeline,这样快速生成一组指引通道(guiding channel),不仅可以保留了目标对象的身份,还兼容 S kora 等人(2019 年)的基于 patch 合成算法的速度更快变体。

得益于这些方法上的改进,研究者创建了首个即使在移动端,也可以将单个肖像的艺术风格实时迁移至目标视频中人脸的系统框架